Docker, 4. Auflage

Das Praxisbuch für Entwickler und DevOps-Teams, von Bernd Öggl und Michael Kofler.

[Weiterlesen]

Das Praxisbuch für Entwickler und DevOps-Teams, von Bernd Öggl und Michael Kofler.

[Weiterlesen]

Das Praxisbuch für Entwickler und DevOps-Teams, von Bernd Öggl und Michael Kofler.

[Weiterlesen]

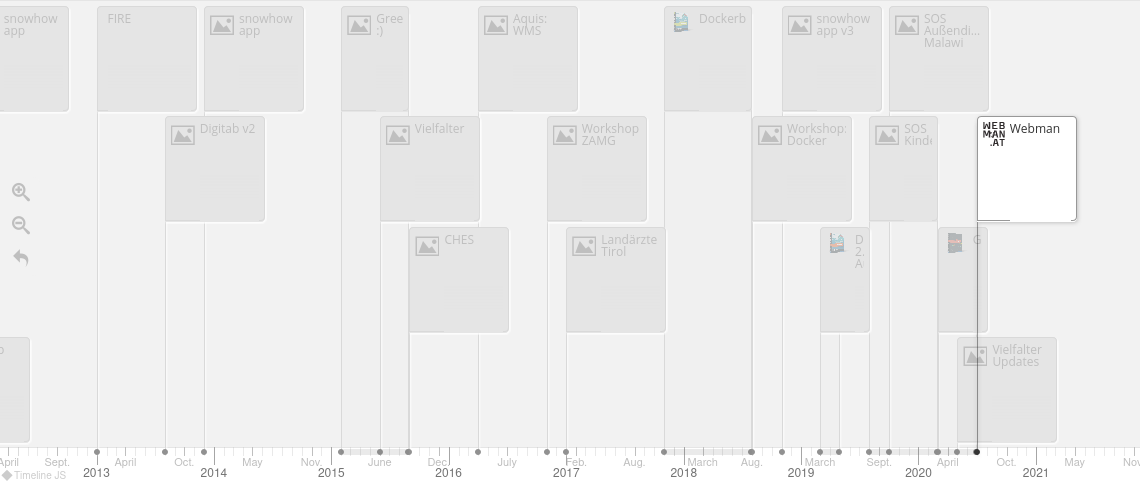

Es ist zwar schon seit zwei Wochen im Handel erhältlich, aber ein aktuelles Projekt ließ mir nicht einmal die Zeit den kurzen Blog-Eintrag dazu zu verfassen.

[Weiterlesen]

Da der anstehende Urlaub der erste seit langer Zeit ohne Laptop sein wird (die Fahrradtaschen bieten nur begrenzt Speicherplatz), suchte ich nach einem seriösen SSH-Client für das Android Mobiltelefon. Da die Zugänge auf meinen Servern inzwischen ausschließlich mit den SSH-Keys auf meinen beiden Yubikeys abgesichert sind, war die Anforderung, dass der Client die Schlüssel von dem Hardware-Token verwenden kann.

[Weiterlesen]

Nach ziemlich genau 19,5 Jahren wird aus komplett.cc webman.at.

[Weiterlesen]